Новинар на „Вајс“ неодамна си влегол во банкарската сметка со копија на неговиот глас создадена од вештачка интелигенција. Пред неколку денa се појавиja лажни експлицитни слики од Тејлор Свифт создадени од вештачка интелигенција. Робот со гласот на Бајден ги предупредил гласачите да не гласаат.

Пред 20 години, ова беше сценарио од дистописки научно-фантастичен филм. Денес се вистински вести. Технологијата секој ден напредува сѐ побргу, веродостојно на предвидувањата на Муровиот закон кој вели дека технологијата експоненцијално ќе станува побрза, помала и поевтина. Можноста за создавање статии, слики, гласови, па и лажни видеа со помош на вештачката интелигенција укажува на промена на парадигмата во поглед на кибербезбедноста, но и на општата безбедност. Таквата алатка лесно може да се искористи за валкање на чија било репутација, за економски измами и ред други нешта со сериозни политички, општествени и психолошки последици.

Само имагинацијата на измамникот е лимитот. Стравот од моќта на роботите и на вештачката интелигенција се појавува уште пред чудовиштето на Франкенштајн, па со развојот на науката станува една од главните теми на научната фантастика.

Во филмот „Таа“, главниот протагонист е вдовец кој нарачува робот што ја имитира жена му. Роботот ги користи сите информации за жена му (е-пораки, говорни пораки, белешки и др.) за да научи како совршено да ја имитира.

(Слика од филмот „Таа“ преземена од „Имдб“)

Што е аудио дипфејк?

Лажните гласови веќе се дел од секојдневието. Популарниот назив за нив е „аудио дипфејк“, еден од серијата називи за вештачката интелигенција „дипфејк“. „Дипфејк“ се користи за создавање лажни слики, видеа или каква било содржина која изгледа убедливо. Користи два алгоритма, генератор и дискриминатор, за да ја рафинира лажната содржина. Генераторот создава податоци за тренирање зависно од потребниот излез, со што создава лажна дигитална содржина. Дискриминаторот ги анализира веродостојноста и реалистичноста на содржината. Вештачката интелигенција „учи“ со повторување на овој процес, па генераторот напредува при создавањето реалистична содржина, а дискриминаторот станува повешт во наоѓањето грешки за да го поправи генераторот. Практично, ова е взаемна спрега во која двата алгоритма се подобруваат додека не создадат речиси совршена содржина зависно од потребите.

– Аудио дипфејк функционира така што се тренираат невронски мрежи кои се принципот на кој работат алгоритмите за вештачка интелигенција. Тие добиваат влез во форма на аудио запис за да го реплицираат многу прецизно. Пример за ова е снимка со добар аудио квалитет од говор на некој поединец. Што подолг е записот, толку подобро невронската мрежа го учи секој аспект (тоналитетот, модулацијата на гласот, фреквенциите итн.). Секако, подобро е и ако за влезот се земат повеќе говори од истата личност бидејќи вештачката интелигенција ќе научи и различни експресии и микроекспресии во говорот. Така се создава моделот, па секој говор се реплицира за да звучи исто како личноста – објаснува професор д-р Бруно Џоговиќ, експерт за кибербезбедност и професор на универзитетот Метрополитeн во Осло, Норвешка.

Но тоа доаѓа со реперкусии, според професор Џоговиќ. Говорот мора да биде со одличен аудио квалитет, но и тогаш постојат детали според кои се одредува вистинитоста на аудио записот. Сепак, во перцепцијата на просечната личност, овие записи се исти како оригиналот.

– Досега може да се детектираат 100% од вештачките содржини со помош на вештачка интелигенција тренирана за таа цел, а тие апликации се приоритет за развој на информациската безбедност. А и малициозните личности пружаат напори за создавање софтвер кој служи само за измама на безбедносните системи за детекција на дипфејк содржини. Тие создаваат клучни елементи на кои се фокусира системот за детекција, па така може погрешно да научи како да ги открива овие содржини. Ова е сложен проблем во дигиталната безбедност и повеќе се користи за кибер напади одошто во дипфејк технологијата сега за сега – тврди професор Џоговиќ.

Ало мамо, јас сум, помагај!

Вештачката интелигенција може да создава гласови кои звучат како гласови на членови од семејството, познати поп ѕвезди и политичари. Измамниците лесно можат да имитираат член на семејството за да му се јават на друг член, да го измамат и да го ограбат. Вештачките гласови можат да се порачаат од компании за одредена сума пари, а некои од нив се бесплатни за користење. Има онлајн веб-страни кои дури дозволуваат бесплатно користење на аудио дипфејк гласови на познати личности. Таква веб-страна е „Топ медиаи“.

Вака би звучел еден кус разговор меѓу Илон Маск и Морган Фримен.

Audio Player

Audio Player

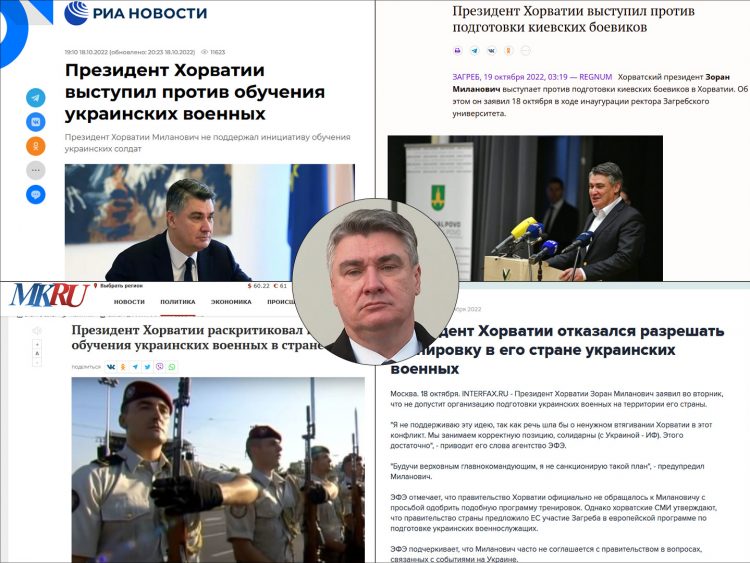

Најопасни се содржините создадени со политички или стратешки цели. Тогаш може да се реплицираат гласови на претседатели, премиери или новинари кои би доставувале лажни вести за граѓаните. Последиците за општеството и степенот на влијание на луѓето не можат да се предвидат. Сепак, многумина се скептични за информациите добиени преку медиумите, па можат да препознаат вакви содржини кои ќе ги класифицираат како лажни. Веста бргу би се проширила и на јавноста би ѝ било јасно дека станува збор за лажна содржина. Постојат напори за создавање софистицирани алгоритми способни да препознаат детали од аудио записите. Овие алгоритми би ги споредиле записите со оригиналните за да решат дали станува збор за лажна содржина. Истото важи за слики и за други примени на вештачката интелигенција за негативни цели – вели Џоговиќ, експерт за мрежно инженерство и кибербезбедност.

Фактот што светот е добро поврзан и Западот практикува слобода на говор може значајно да ја оспори примената на дипфејк содржините. Ако некој открие дека некое аудио е дипфејк, информацијата бргу ќе се прошири и луѓето ќе знаат дека станува збор за лажно рекреирана содржина. Сепак, во некои општества, дипфејк технологијата може да има многу поголемо влијание. Пример е Кина каде што цензурата е на високо ниво и владата целосно го контролира текот на информациите преку Интернетот. Тогаш би било лесно да се цензурираат оние кои сфатиле дека содржината е дипфејк – вели професор Џоговиќ.

Што може да се стори?

Останува клишето како дискусија. Дали самата технологија е опасна или, пак, е корисна во вистинските раце, а опасен е тој кој ја користи? Технологијата сама по себе не е лоша ни добра бидејќи таа нема свест за да има етички принципи и намера. Луѓето кои ја користат имаат намери и се опасни. Сценариото во кое вештачката интелигенција развива самосвест и контрола врз сѐ не е остварено, па сега засега може да ѝ се ограничи моќта со практични технолошки промени, закони и општа едукација.

Професор Џоговиќ го препорачува критичкото размислување како најдобар начин за заштита од овие содржини.

– За жал, многумина буквално ги сфаќаат вестите и тешко е да се препознае нешто без детален преглед и подлабоко истражување на веста. Вообичаено, луѓето треба да ги истражуваат содржините кои немаат смисла или се сомнителни. Но, ако зборуваме за совршено создаден дипфејк материјал, тогаш е невозможно да се разликува од легитимниот материјал – вели професор Џоговиќ.

Во морето податоци на Интернет, имањето соодветни алатки за разликување на лажни информации од вистински е нужно.

Кои се шансите да ви се јави член на семејството и одеднаш да ви побара пари на сомнителна сметка?